23.08.11 집필

일단 anaconda에서 새로운 가상환경을 만들어봅니다.

$ conda create -n yolo_test python=3.9.17파이썬 버전은 3.9.17로 진행했다.

$ python -m ipykernel --user --name yolo_test

$ conda activate yolo_test이제 가상환경을 열고, yolo를 받아올 준비를 한다.

https://github.com/ultralytics/yolov5

GitHub - ultralytics/yolov5: YOLOv5 🚀 in PyTorch > ONNX > CoreML > TFLite

YOLOv5 🚀 in PyTorch > ONNX > CoreML > TFLite. Contribute to ultralytics/yolov5 development by creating an account on GitHub.

github.com

이 깃허브 주소를 git clone할 예정인데,

가상환경이 유지된 채로 cd를 통해 내가 원하는 주로 이동해준다.

$ git clone https://github.com/ultralytics/yolov5.git만약 이 코드가 오류가 나면 git이 설치되어있지 않은거다. git을 설치하고 재부팅하자.

필수 패키지 다운

이제 새로 만든 가상환경으로 ipynb 파일을 하나 만들고, 아래 코드를 입력하여 설치한다.

!pip install -r ./yolov5/requirements.txt

!pip install utils torch아마 torch는 설치가 안될수도 있다. 이건 따로 pip install torch 하면 된다.

사실상 준비는 이걸로 끝났다. 사용방법은 위의 깃허브에 다 적혀있다

하지만 눈알과 입에 척화비를 세운 나로서는 못알아 먹을 수 있으니, 미래의 나를 위해 글을 남겨두자면,

yolov5테스트

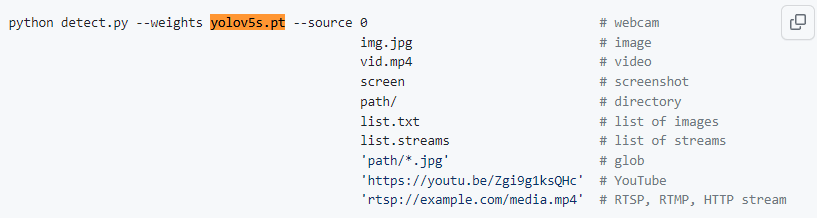

!python ./yolov5/detect.py --weights yolov5s.pt --source 0의 코드를 사용하면, yolov5에 기본으로 학습되어있는 데이터를 이용해 webcam의 영상을 분석한다.

webcam을 사용하는 이유는, --source 옵션 때문인데, 아래의 글을 참조하자.

또한, yolov5s.pt라고 되어있는 *.pt 확장자는, yolo 학습 시 나오는 학습데이터다. 그 중에서도, s는 모델의 크기를 말하는거다.

n < s < m < l < x 크기로 모델의 크기가 커지며, 정확하고 무거워진다.

이들은 git clone시 같이 따라오지 않으며, 위의 코드처럼 작성시에는 자동으로 github에서 다운로드하여 사용하게 된다.

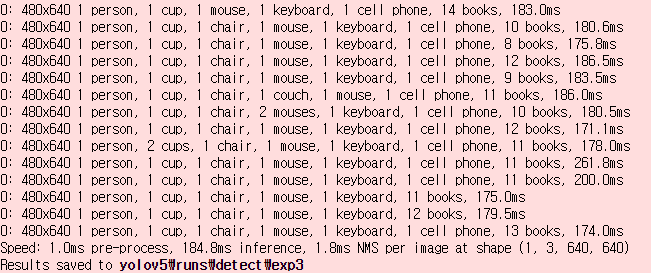

결과 사진은 위와 같다.

s모델을 썼음에도 꽤나 정확하고, 프레임은 좀 떨어진다. 물론 진행한 컴퓨터의 성능이 좀 떨어지긴 한다.

q를 누르면 창이 닫히며, 탐지되었던 객체를 프레임마다 반환한다.

yolov5 segmentation 테스트

!python ./yolov5/segment/predict.py --weights yolov5s-seg.pt --conf 0.25 --source 0사각 영역 표시 뿐만이 아니라, 누끼를 따준다.

아직 많이 해보지 않아서 설명하기 어렵다. 이후에 내용을 추가할 예정.

'SW > 영상처리' 카테고리의 다른 글

| OpenCV) Ubuntu 20.04에 OpenCV 4.4.0 설치 (2) | 2023.05.22 |

|---|---|

| OpenCV) OpenCV및 디지털 영상처리 기초 (0) | 2023.01.22 |